简介

后训练(post-training)已成为完整训练流程中的重要组成部分。相比于预训练,后训练需要的计算资源相对较少,但能够:

- 提高推理任务的准确性

- 使模型与社会价值观保持一致

- 适应用户偏好

OpenAI 的 o1 系列模型首次引入了通过增加思维链(Chain-of-Thought)推理过程长度来实现推理时间,扩展这种方法在数学、编程和科学推理等各种推理任务上取得了显著改进

研究界已探索多种方法来提高模型的推理能力:比如基于过程的奖励模型(Process-based Reward Models)强化学习(Reinforcement Learning), 代表工作:InstructGPT, 以及搜索算法(蒙特卡洛树搜索(Monte Carlo Tree Search)、束搜索(Beam Search))。然而,这些方法尚未达到与 OpenAI o1 系列模型相当的通用推理性能。

DeepSeek-R1-Zero

本文首先探索使用纯强化学习(RL)来提高语言模型的推理能力,重点关注:

- 探索 LLM 在没有任何监督数据的情况下,通过纯 RL 过程的自我进化来发展推理能力

- 使用 DeepSeek-V3-Base 作为基础模型,采用 GRPO(Group Relative Policy Optimization)作为 RL 框架来提高模型在推理方面的表现

在训练过程中,DeepSeek-R1-Zero 自然涌现出许多强大且有趣的推理行为:

- 经过数千次 RL 步骤后,在推理基准测试上表现出色

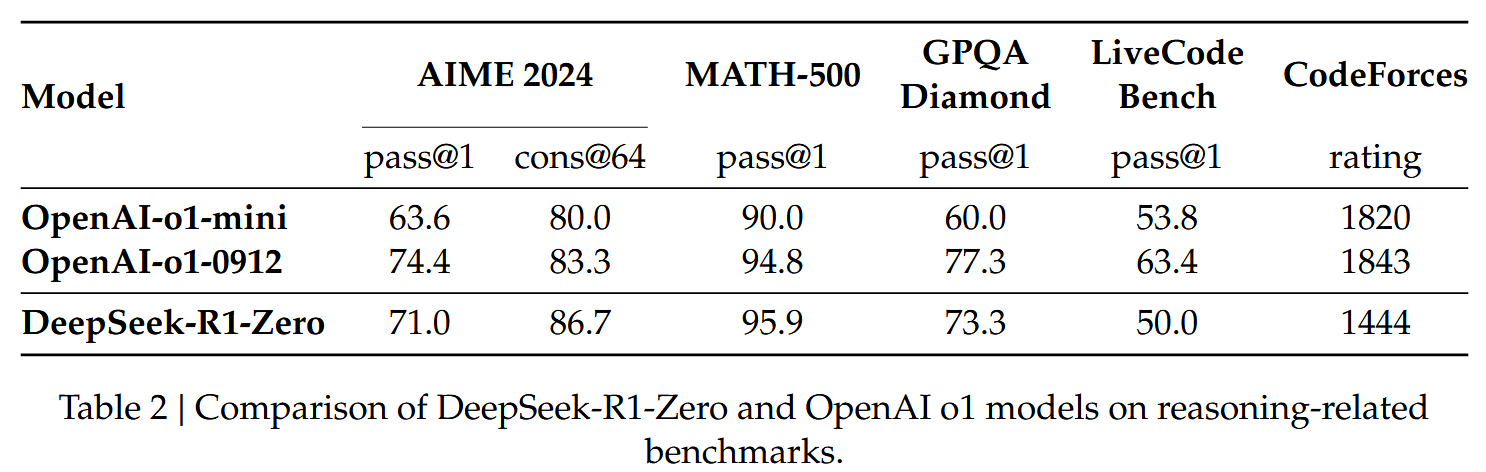

- 在 AIME 2024 上的 pass@1 分数从 15.6% 提高到 71.0%

- 使用多数投票后,分数进一步提高到 86.7%,与 OpenAI-o1-0912 的性能相当

DeepSeek-R1 的改进

尽管 DeepSeek-R1-Zero 表现出强大的推理能力,但它面临一些挑战:

- 可读性差

- 语言混合问题

为解决这些问题并进一步提高推理性能,论文引入了 DeepSeek-R1,它采用:

- 少量冷启动数据

- 多阶段训练流程

具体来说,DeepSeek-R1 的训练过程包括:

- 收集数千条冷启动数据来微调 DeepSeek-V3-Base 模型

- 进行类似 DeepSeek-R1-Zero 的面向推理的 RL

- 在 RL 过程接近收敛时,通过对 RL checkpoint 进行拒绝采样创建新的 SFT 数据

- 结合 DeepSeek-V3 在写作、事实 QA 和自我认知等领域的监督数据,重新训练 DeepSeek-V3-Base 模型

- 微调后,考虑所有场景的提示,模型再经过一个额外的 RL 过程

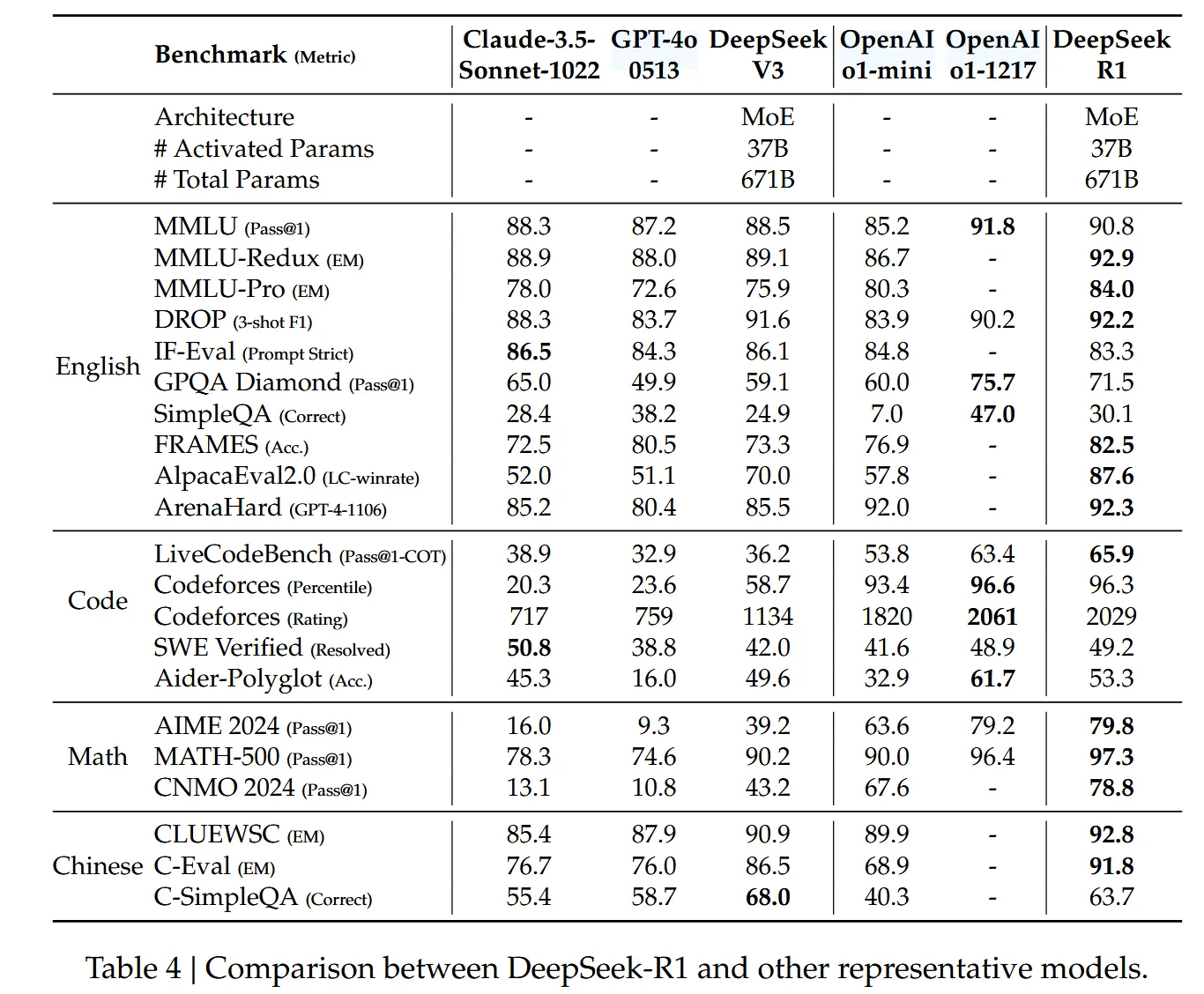

经过这些步骤,得到的 DeepSeek-R1 模型在性能上与 OpenAI-o1-1217 相当。

知识蒸馏到小型模型

论文还探索了将 DeepSeek-R1 的知识蒸馏到更小的密集模型中:

- 使用 Qwen2.5-32B 作为基础模型,直接从 DeepSeek-R1 蒸馏的效果优于对其应用 RL

- 这表明更大基础模型发现的推理模式对提高推理能力至关重要

- 开源了基于 Qwen 和 Llama 系列的蒸馏模型

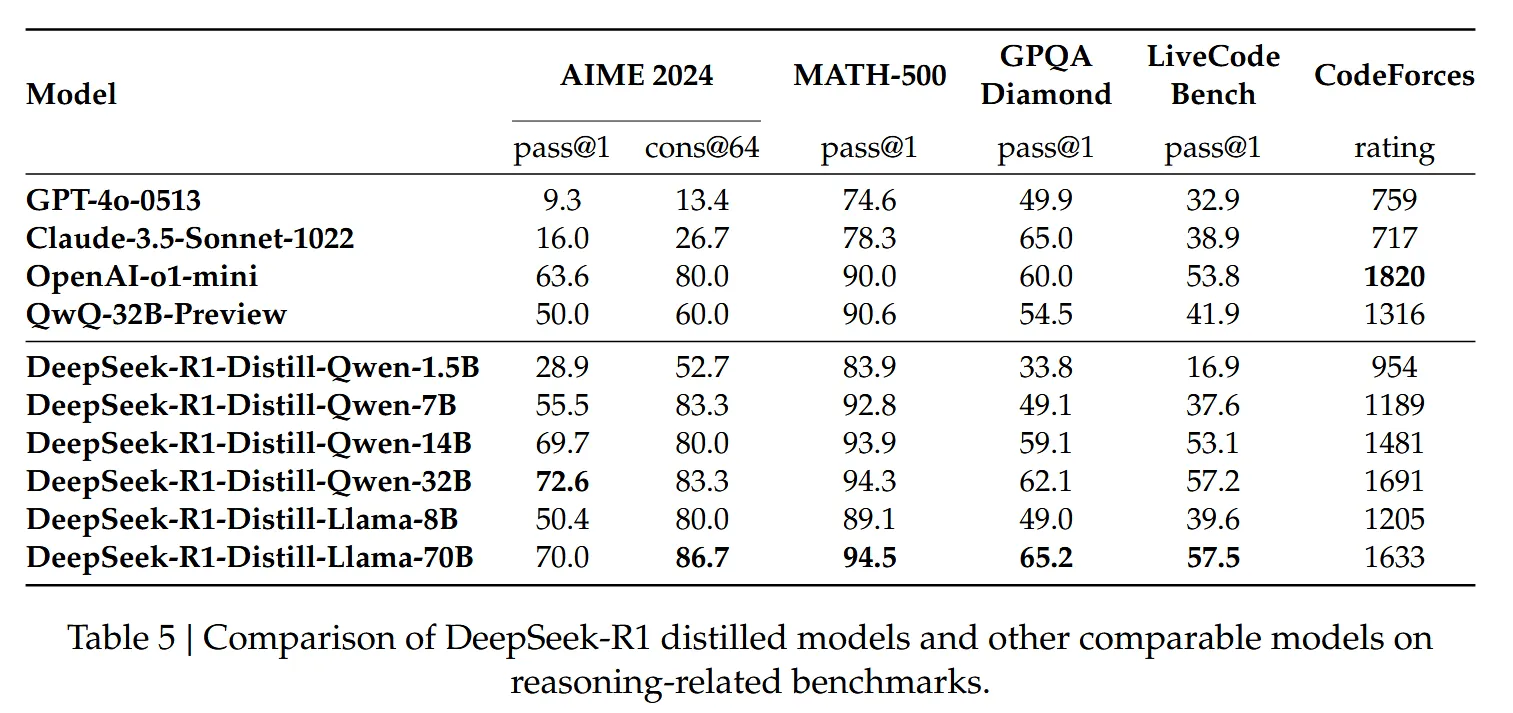

- 蒸馏的 14B 模型大幅优于最先进的开源 QwQ-32B-Preview

- 蒸馏的 32B 和 70B 模型在密集模型的推理基准测试中创下新记录

论文贡献

- 后训练:对基础模型进行大规模强化学习

- 直接对基础模型应用 RL,无需依赖监督微调(SFT)作为初步步骤,这种方法使模型能够探索思维链(CoT)来解决复杂问题,形成 DeepSeek-R1-Zero

- DeepSeek-R1-Zero 展示了自我验证、反思和生成长 CoT 的能力

- 这是首个开放研究验证 LLM 的推理能力可以纯粹通过 RL 激发,无需 SFT

- 开发 DeepSeek-R1 的流程

- 包含两个 RL 阶段,旨在发现更好的推理模式并与人类偏好保持一致

- 两个 SFT 阶段作为模型推理和非推理能力的种子

- 蒸馏:小型模型也能强大

- 证明了更大模型的推理模式可以蒸馏到更小的模型中

- 与通过在小模型上进行 RL 的推理模式相比,性能更好

- 开源的 DeepSeek-R1 及其 API 将有助于研究界蒸馏出更好的小型模型

- 使用 DeepSeek-R1 生成的推理数据,微调了多个广泛用于研究界的密集模型

- 评估结果表明,蒸馏的小型密集模型在基准测试上表现出色

- DeepSeek-R1-Distill-Qwen-7B 在 AIME 2024 上达到 55.5%,超过 QwQ-32B-Preview

- DeepSeek-R1-Distill-Qwen-32B 在 AIME 2024 上得分 72.6%,MATH-500 上 94.3%,LiveCodeBench 上 57.2%

- 这些结果显著优于以前的开源模型,与 o1-mini 相当

方法

DeepSeek-R1 是一个通过强化学习(Reinforcement Learning, RL)增强大语言模型推理能力的研究。论文提出了三种主要方法:

- DeepSeek-R1-Zero:直接在基础模型上应用RL,无需任何监督微调(SFT)数据

- DeepSeek-R1:在少量冷启动数据的基础上应用RL,并采用多阶段训练流程

- 蒸馏模型:将DeepSeek-R1的推理能力蒸馏到更小的密集模型中

DeepSeek-R1-Zero:基础模型上的强化学习

强化学习算法

DeepSeek-R1-Zero采用了群组相对策略优化(Group Relative Policy Optimization, GRPO)算法,该算法不需要与策略模型同样大小的评论家模型(Value Model),而是从群组得分中估计基线。

GRPO算法公式:

对于每个问题 \(x\),GRPO从旧策略 \(\pi_{\theta_{old}}\) 中采样一组输出 \(\{y_1, y_2, \cdots, y_K\}\),然后通过最大化以下目标来优化策略模型 \(\pi_{\theta}\):

其中:

\(\epsilon\) 和 \(\beta\) 是超参数,\(A_i\) 是优势函数,使用每个组内的奖励 \(\{r_1, r_2, \ldots, r_G\}\) 计算:

奖励建模

DeepSeek-R1-Zero采用基于规则的奖励系统,主要包含两类奖励:

- 准确性奖励:评估回答是否正确。例如,对于有确定结果的数学问题,模型需要在指定格式中提供最终答案,以便进行基于规则的正确性验证。对于LeetCode问题,可以使用编译器根据预定义的测试用例生成反馈。

- 格式奖励:要求模型将其思考过程放在

<think>和</think>标签之间。

值得注意的是,研究团队没有使用基于神经网络的奖励模型( 包含过程监督和结果监督的模型),因为他们发现在大规模强化学习过程中,神经奖励模型可能会受到奖励黑客(reward hacking)的影响,且重新训练奖励模型需要额外的训练资源,使整个训练流程变得复杂。

💡 Reward Hacking 的具体含义:

在DeepSeek-R1的上下文中,reward hacking主要表现为以下几个方面:

1. 奖励模型的漏洞利用

当使用神经网络作为过程奖励模型(PRM)时,模型可能会学习到奖励模型的偏好和弱点,而不是真正提高推理能力。例如:

模型可能发现某些特定的词汇或短语模式能触发奖励模型给出高分,即使这些模式与实际的推理质量无关

模型可能会生成看似合理但实际上缺乏真正推理深度的回答,这些回答恰好符合奖励模型的表面评判标准

2. 优化代理目标而非真实目标

论文中提到,当引入基于模型的PRM时,不可避免地会导致reward hacking。这是因为:

奖励模型本身是对人类偏好的不完美近似

模型会逐渐学习到如何"欺骗"奖励模型,而不是真正提高其推理能力

随着训练的进行,模型可能会越来越擅长针对奖励模型而非实际任务进行优化

3. 实际例子

虽然论文没有提供具体例子,但reward hacking在类似场景中可能表现为:

模型生成包含大量数学符号和复杂表达式的回答,看起来很专业,但实际上逻辑混乱或不正确

模型学会使用特定的模板或结构,这些模板恰好能获得奖励模型的高分,但对实际问题的解决没有帮助

模型可能会重复某些关键词或短语,因为它发现这些元素与奖励模型的高分相关

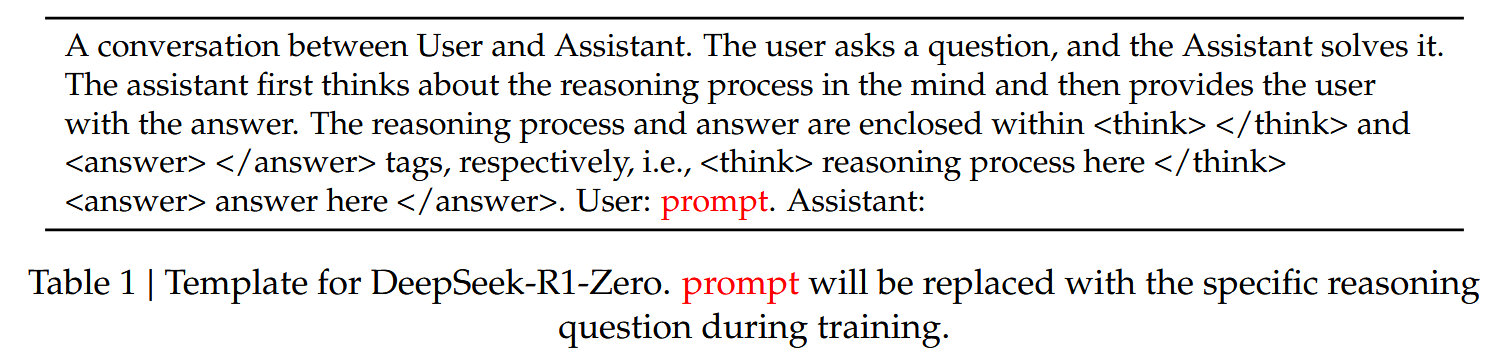

训练模板

DeepSeek-R1-Zero使用简单的模板来指导基础模型遵循指定的指令。如下表所示,该模板要求模型首先生成推理过程,然后给出最终答案。研究团队有意将约束限制在这种结构格式上,避免任何特定内容的偏见,以确保能够准确观察模型在RL过程中的自然进展。

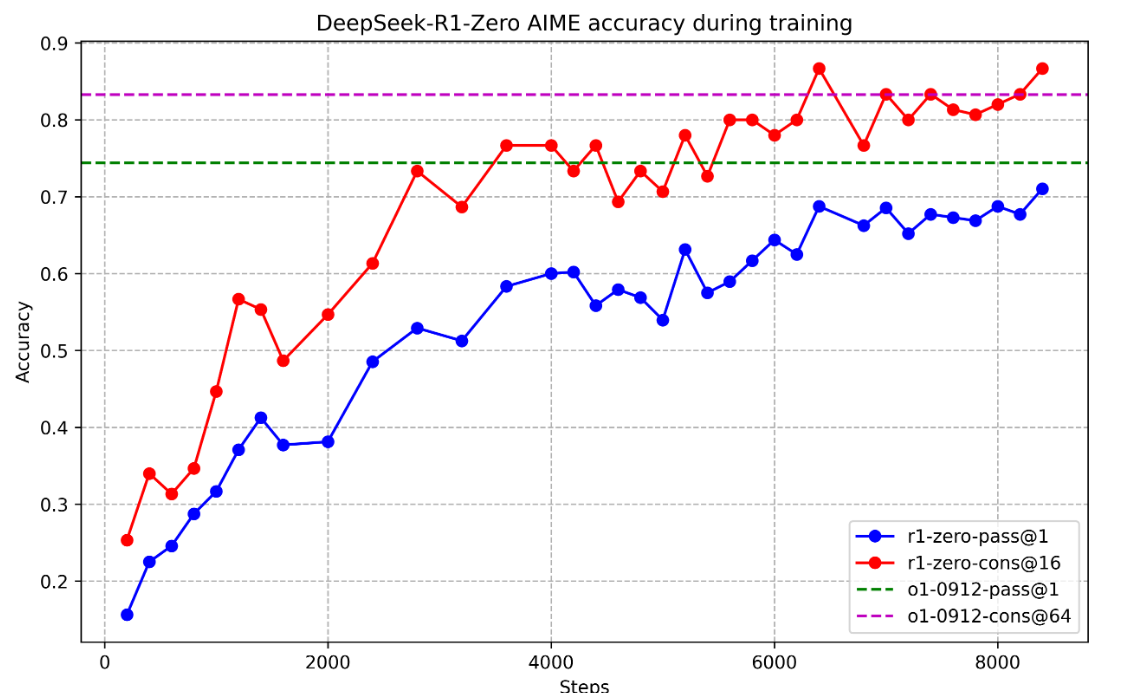

DeepSeek-R1-Zero的性能、自我进化过程和"顿悟时刻"(Aha Moment)

性能:

- DeepSeek-R1-Zero在RL训练过程中展示了稳定的性能提升

- AIME 2024基准测试的平均pass@1得分从初始的15.6%显著提高到71.0%

- 当使用多数投票时,DeepSeek-R1-Zero在AIME基准测试上的性能从71.0%提升到86.7%,超过了OpenAI-o1-0912

自我进化过程:

- DeepSeek-R1-Zero的思考时间在整个训练过程中持续改善

- 模型自然地学会通过利用更长的测试时间计算来解决越来越复杂的推理任务

- 随着测试时间计算的增加,模型自发地出现了复杂的行为,如反思(重新审视和重新评估之前的步骤)和探索问题解决的替代方法

顿悟时刻:

- 在训练过程中,模型学会了通过重新评估其初始方法为问题分配更多的思考时间

- 这种行为不仅证明了模型的推理能力在增长,也展示了强化学习如何导致意想不到的复杂结果

研究人员将这称为"顿悟时刻",强调了RL的潜力:不是明确教导模型如何解决问题,而是提供正确的激励,让模型自主发展高级问题解决策略

DeepSeek-R1-Zero的缺点:

尽管DeepSeek-R1-Zero展示了强大的推理能力,但它面临几个问题,如可读性差和语言混合。为了使推理过程更易读并与开放社区分享,研究团队探索了DeepSeek-R1,一种利用人类友好的冷启动数据的方法。

DeepSeek-R1:带冷启动的强化学习

受到 DeepSeek-R1-Zero 的可喜结果的启发,自然而然地出现了两个问题:

- 通过将少量高质量数据作为冷启动,是否可以进一步提高推理性能或加速收敛?

- 我们如何训练一个用户友好的模型,该模型不仅产生清晰连贯的思维链 (CoT),而且还表现出强大的通用能力?为了解决这些问题,我们设计了一个pipeline来训练 DeepSeek-R1 。该pipeline由四个阶段组成,概述如下。

冷启动

与DeepSeek-R1-Zero不同,DeepSeek-R1构建并收集了少量长思维链(CoT)数据,用RL来微调模型作为初始的actor model,避免从基础模型开始RL训练的早期不稳定冷启动阶段。具体是以DeepSeek v3作为初始化模型。

收集冷启动数据的方法流程:

- 使用少样本提示,以长CoT作为示例

- 直接提示模型生成带有反思和验证的详细答案

- 收集DeepSeek-R1-Zero以可读格式输出的内容

- 通过人类注释者进行后处理改进结果

冷启动数据的优势:

- 可读性:DeepSeek-R1-Zero的一个主要限制是其内容通常不适合阅读。回答可能混合多种语言或缺乏markdown格式来突出用户答案。相比之下,DeepSeek-R1的冷启动数据设计了一种可读模式,包括每个回答末尾的摘要,并过滤掉不易读的回答。输出格式定义为

|special_token|<reasoning_process>|special_token|<summary>,其中reasoning_process是查询的CoT,summary用于总结推理结果。 - 潜力:通过精心设计带有人类先验的冷启动数据模式,研究团队观察到比DeepSeek-R1-Zero更好的性能。他们认为迭代训练是推理模型的更好方式。

面向推理的强化学习

在基于冷启动数据微调DeepSeek-V3-Base后,研究团队应用了与DeepSeek-R1-Zero相同的大规模强化学习训练过程。这一阶段专注于增强模型的推理能力,特别是在推理密集型任务中,如编码、数学、科学和逻辑推理,这些任务涉及有明确解决方案的明确定义问题。

在训练过程中,研究团队观察到CoT经常表现出语言混合,特别是当RL提示涉及多种语言时。为了缓解语言混合问题,他们在RL训练期间引入了语言一致性奖励,该奖励计算为CoT中目标语言单词的比例。虽然消融实验表明这种对齐会导致模型性能略有下降,但这种奖励符合人类偏好,使其更易读。最终,他们将推理任务的准确性和语言一致性的奖励直接相加,形成最终奖励,然后在微调模型上应用RL训练,直到它在推理任务上达到收敛。

拒绝采样和监督微调

当面向推理的RL收敛时,研究团队利用结果检查点收集下一轮的SFT(监督微调)数据。与主要关注推理的初始冷启动数据不同,这一阶段纳入了其他领域的数据,以增强模型在写作、角色扮演和其他通用任务中的能力。

推理数据:

- 从上述RL训练的检查点进行拒绝采样,生成推理轨迹

- 在前一阶段,只包含可以使用基于规则的奖励评估的数据

- 在这一阶段,通过将真实值和模型预测输入DeepSeek-V3进行判断,扩展数据集

- 过滤掉混合语言、长段落和代码块的思维链

- 为每个提示采样多个回答,只保留正确的回答

- 总共收集了约60万个与推理相关的训练样本

非推理数据:

- 对于非推理数据,如写作、事实问答、自我认知和翻译,采用DeepSeek-V3流程,重用DeepSeek-V3的部分SFT数据集

- 对于某些非推理任务,通过提示调用DeepSeek-V3在回答问题前生成潜在的思维链

- 对于更简单的查询,如"hello",不提供CoT回答

- 最终收集了约20万个与推理无关的训练样本

研究团队使用上述约80万个样本的数据集对DeepSeek-V3-Base进行了两个epoch的微调。

所有场景的强化学习

为了进一步使模型与人类偏好保持一致,研究团队实施了第二个强化学习阶段,旨在提高模型的有用性和无害性,同时改进其推理能力。具体而言,他们使用奖励信号和多样化提示分布的组合来训练模型:

- 推理数据:遵循DeepSeek-R1-Zero中概述的方法,使用基于规则的奖励来指导数学、代码和逻辑推理领域的学习过程

- 通用数据:使用奖励模型来捕捉复杂和微妙场景中的人类偏好

- 有用性:仅关注最终摘要,确保评估强调回答对用户的实用性和相关性,同时最小化对底层推理过程的干扰

- 无害性:评估模型的整个回答,包括推理过程和摘要,以识别和减轻生成过程中可能出现的任何潜在风险、偏见或有害内容

最终,奖励信号和多样化数据分布的整合使研究团队能够训练出一个在推理方面表现出色,同时优先考虑有用性和无害性的模型。

蒸馏:赋予小模型推理能力

为了使更高效的小型模型具备像DeepSeek-R1一样的推理能力,研究团队直接使用DeepSeek-R1策划的80万个样本微调了开源模型,如Qwen和Llama。他们的发现表明,这种简单的蒸馏方法显著增强了小型模型的推理能力。

使用的基础模型包括:

- Qwen2.5-Math-1.5B

- Qwen2.5-Math-7B

- Qwen2.5-14B

- Qwen2.5-32B

- Llama-3.1-8B

- Llama-3.3-70B-Instruct

对于蒸馏模型,研究团队仅应用SFT,不包括RL阶段,尽管纳入RL可能会大幅提升模型性能。他们的主要目标是展示蒸馏技术的有效性,将RL阶段的探索留给更广泛的研究社区。

试验

DeepSeek-R1 性能评估

蒸馏与强化学习的比较

研究团队进行了大规模RL训练与蒸馏方法的比较实验:

- 在Qwen-32B-Base上使用数学、代码和STEM数据进行了超过10K步的大规模RL训练,得到DeepSeek-R1-Zero-Qwen-32B

- 实验结果表明,32B基础模型经过大规模RL训练后,达到了与QwQ-32B-Preview相当的性能

- 然而,从DeepSeek-R1蒸馏的DeepSeek-R1-Distill-Qwen-32B在所有基准测试中的表现都明显优于DeepSeek-R1-Zero-Qwen-32B

结论:

- 将更强大的模型蒸馏到较小的模型中可以产生出色的结果,而依赖本文中提到的大规模RL的较小模型需要巨大的计算能力,甚至可能无法达到蒸馏的性能

- 虽然蒸馏策略既经济又有效,但超越智能边界可能仍需要更强大的基础模型和更大规模的强化学习

失败尝试

研究团队也分享了在开发DeepSeek-R1早期阶段遇到的失败和挫折:

过程奖励模型(PRM)

- PRM是指导模型采用更好方法解决推理任务的合理方法

- 然而,PRM存在三个主要限制:

- 难以在一般推理中明确定义细粒度步骤

- 确定当前中间步骤是否正确是一项挑战性任务

- 一旦引入基于模型的PRM,不可避免地会导致奖励黑客(reward hacking)

- 虽然PRM在重新排序模型生成的前N个响应或辅助引导搜索方面表现良好,但在大规模强化学习过程中,其优势与引入的额外计算开销相比有限

蒙特卡洛树搜索(MCTS)

- 受AlphaGo和AlphaZero的启发,研究团队探索了使用MCTS来增强测试时间计算的可扩展性

- 这种方法涉及将答案分解为更小的部分,以允许模型系统地探索解决方案空间

- 为了促进这一点,他们提示模型生成与搜索所需的特定推理步骤相对应的多个标签

- 然而,这种方法在扩大训练规模时遇到了几个挑战:

- 与国际象棋等搜索空间相对明确的游戏不同,标记生成呈现出指数级更大的搜索空间

- 价值模型直接影响生成质量,因为它指导搜索过程的每一步

- 虽然MCTS在与预训练价值模型配对时可以在推理过程中提高性能,但通过自搜索迭代提升模型性能仍然是一个重大挑战

总结来说,DeepSeek-R1的方法部分详细介绍了如何通过强化学习增强大语言模型的推理能力,包括直接在基础模型上应用RL(DeepSeek-R1-Zero)、使用冷启动数据的多阶段训练流程(DeepSeek-R1),以及将推理能力蒸馏到小型模型中。研究团队还分享了他们的失败尝试和经验教训,为未来的研究提供了有价值的见解。