摘要

DPANet: Depth Potentiality-Aware Gated Attention Network for RGB-D Salient Object Detection

在RGB-D显著目标检测中,主要存在两个问题:

- 如何有效地整合跨模态RGB-D数据的互补性

- 如何防止不可靠深度图的污染效应。

实际上,这两个问题是相互联系、相互交织的,但以往的方法往往只关注第一个问题,而忽略了对深度图质量的考虑,这可能导致模型陷入次优状态。在本文中,我们在一个整体模型中协同地解决这两个问题,并提出了一个新的网络DPANet来显式地建模深度图的潜力并有效地整合跨模态互补性。通过引入深度潜势感知,网络能够以学习的方式感知深度信息的潜势,指导两模态数据的融合过程,防止污染的发生。融合过程中的门控多模态注意模块利用门控制器的注意机制,从跨模态的角度捕捉长距离的依附性。

主要工作与贡献

- 首次提出了端到端的RGB-D SOD网络中不可靠的深度图,并将深度潜在感知引入到跨模态集成管道中,提出了DPANet。

- 在不增加训练标签(即深度质量标签)的情况下,我们建立了一个面向任务的深度潜力感知模块,该模块能够自适应地感知输入深度图的潜力,进一步削弱不可靠深度信息的污染。

- 我们提出了一个GMA模块来有效地聚合RGB和深度图像的跨模态互补性,其中空间注意机制旨在减少信息冗余,门控制器则侧重于调节跨模态信息的融合率。

- 在没有任何预处理(例如,HHA)或后处理(例如,CRF)技术的情况下,所提出的网络在定量和定性评估方面优于8个RGB-D SOD数据集的16种最新方法。

算法流程

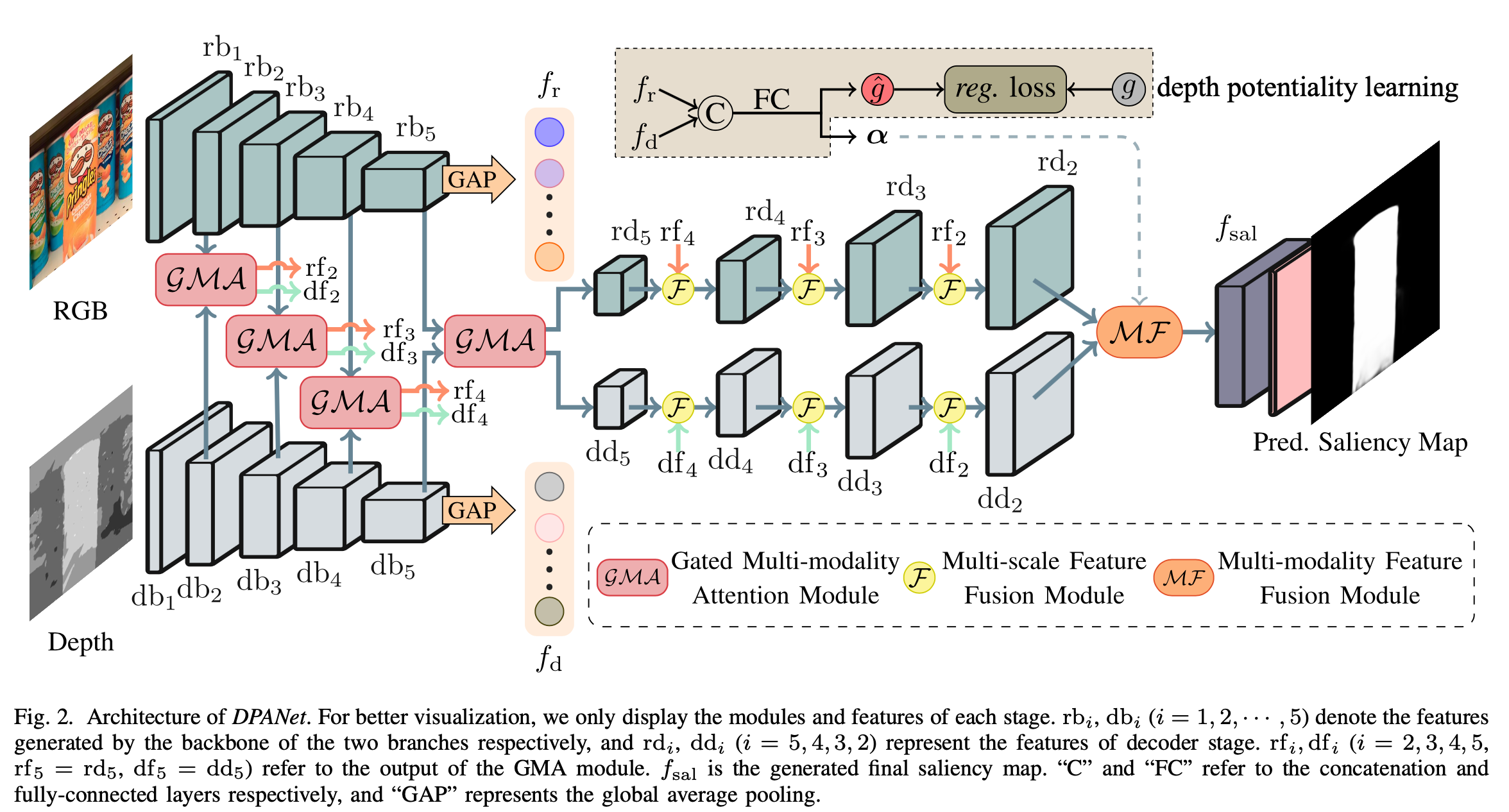

网络结构

RGB分支解码过程所输出的特征定义为 \(rb_i(i = 1,2,3,4,5)\),深度流分支的解码过程的输出定义为\(db_i(i=1,2,3,4,5)\) 分别馈入GMA模块以分别获得相应的增强特征 \(rf_i,df_i\),在GMA模块中,gate的权重是由网络以有监督的方式来学习的顶层特征和穿过全局平均池化(GAP)层和两个完全连接的层,以借助伪标签通过回归损失学习深度潜力的预测两个分支的解码器逐步集成多尺度特征。最后,我们使用“多尺度和多模态融合模块”来汇总两个解码器的输出并生成显著性图。

Depth Potentiality Perception

与之前的工作不同的是,本文提出的网络可以显式地对深度图的置信度响应建模并以一种柔和的方式控制融合过程,而不是直接丢弃低质量的深度图。

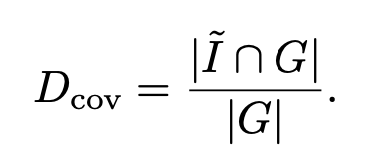

该方法基于一种观察:如果被阀值分割的二进制深度图接近真值,则深度图是高度可靠的,因此应该为该深度输入分配更高的置信度响应。具体来说,首先应用Otsu算法将深度图 \(I\) 转化为二进制深度图 \(\widetilde{I}\)。他从显著性角度描述了深度图的潜力。然后,我们设计了一种度量以评估二进制深度图与真值图之间的相关程度。

采用IoU(intersection over union)来测量二进制图与真值之间的精度。可以表示为

| · |表示区域,在某些情况下, 粗略的二进制深度图将包含背景,这将导致IOU趋于变小,即使最终的显著图与真值图之间非常接近也会是如此。

指标\(D_{cov}\) 反映了相交面积与真值图之间的比率,这表明二进制深度图有望覆盖更加完整的显著对象。最后受F-Measure的启发,我们将这两个度量结合起来以衡量深度图对SOD任务的潜力。

具体的深度图的可靠分数学习方式如网络结构图中右上角所示,通过FC利用\(f_r\)和\(f_d\)的结合学习得到\(\hat{g}\),与\(D(\widetilde{I},G)\)通过reg loss 约束。

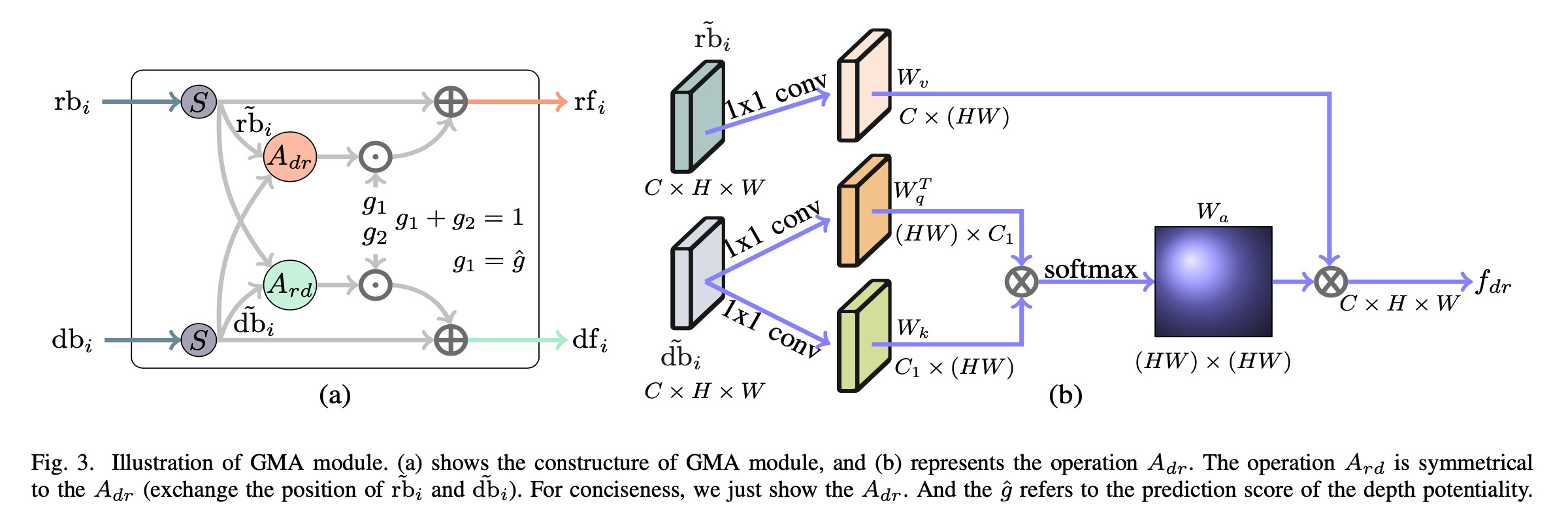

Gated Multi-modality Attention Module

其中 S 表示 spatial attention 操作如下

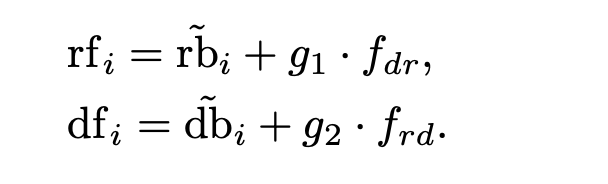

得到更新的特征\(\widetilde{rb}_i\) 和 \(\widetilde{db}_i\)。随后利用non-local的形式得到\(A_{dr}\)和\(A_{rd}\)。self-attention 的操作如右上图所示。最后,我们引入用\(g_1 + g_2 = 1\) 约束的门 \(g_1\) 和 \(g_2\) 来控制增强特征和修改特征的相互作用,可以将其表示为

其中,\(g_1=\hat{g}\)。具体来说,当 \(\hat{g}\) 接近1时,表示深度图是高度可靠的,就将更多的深度信息引入RGB分支以减少背景干扰。当\(\hat{g}\) 接近0时,RGB分支将成为主要分支,而采用的深度信息将更少,并且RGB信息将在防止污染方面发挥更重要的作用。可视化效果如图,

Multi-level Feature Fusion

Multi-scale Feature Fusion

low-level 特征可以提供更多详细信息,例如边界,纹理和空间结构,但可能对背景噪声敏感。high-level 特征包含更多的语义信息,这有助于定位显着对象并抑制噪声。

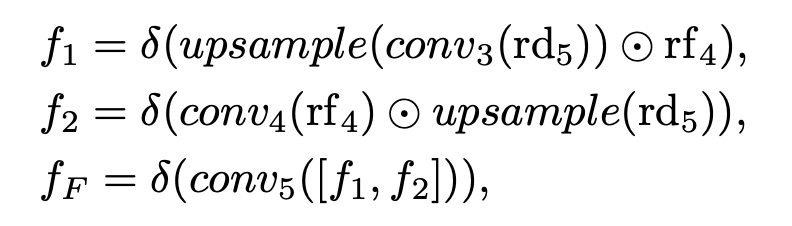

与先前的著作通常通过级联或求和运算来融合low-level特征和hign-level特征不同,我们采取更加有效的方法(比如:乘法),乘法运算可以增强突出对象的响应,同时抑制背景噪声。具体地,以higher-level融合特征\(rd_5\)和low-level特征\(rf_4\)的融合为例,可以将多尺度特征融合描述为:

Multi-modality Feature Fusion

从RGB和深度信息中学习的权重向量。\(\hat{g}\) 是前面提到的门的学习权重。\(f_4\) 反映了对显著物体的共同响应,而 \(f_3\) 通过通道选择(\(α\))和门控机制(\(\hat{g}\))集合了联众模态特征,以考虑互补性和不一致性。